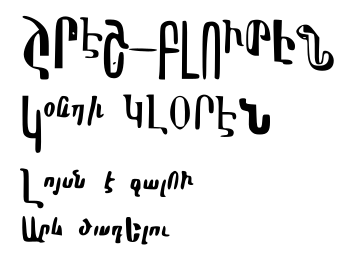

https://world.hey.com/dhh/why-don-t-more-people-use-linux-33b75f53

ես dhh֊ի հետ համամիտ չեմ։ պայմանական «լինուքս» օգտավործելն էսօր ոչ մի հմտութիւն չի էլ պահանջում։ աւելին, այն աւելի հեշտ ա տեղակայել քան «ուինը»։

եւ դրա տակ աւելի հեշտ ա ծրագրեր տեղակայել։

ես կարծում եմ որ կայ երկու֊երեք հիմնական պատճառ՝

ա) իներցիա։

շատ հզօր ուժ ա իներցիան։ մի պեդալների պտոյտ ու գնում ես հարիւր մետր։ օպերացիոն համակարգի/էկոհամակարգի իներցիայի դէպքում վստահ չեմ որ կայ հակազդող շփման ուժը կամ լանդշաֆտի փոփոխութիւնը։

մայքրոսոֆթը նոյնիսկ թոյլ ա տալիս ոչ արտօնագրուած «ուինդոուս» օգտագործել՝ որ իներցիային հակազդող ուժ չլինի։ դու չես վճարի՝ միւսը կը վճարի։ բայց դու չօգտուես՝ միւսը կարող ա նոյնպէս չուզի օգտուել։

նաեւ կան կորպորատիւ խաղեր՝ որ կապեն քեզ իրենց էկօհամակարգին ու չկարողանաս դուրս գալ։

իներցիայի օրինակ՝ ծրագրեր որ մարդիկ սովոր են օգտագործել։ նրանք հազիւ են սովորել պայմանական «ֆոտոշոփ»֊ին, ու արդէն իրենց վերջն են զգում եթէ մի երկու «առաջադէմ» օգտագործման ձեւ գիտեն։

բ) մարդիկ չգիտեն որ կայ այընտրանք։ ոմանք գիտեն որ կայ տարօրինակ մակերի աշխարհ։

գ) մարդիկ չեն ընտրում։ մարդիկ ցանկացած օպերացիոն համակարգն անուանում են «ուինդոուս»։

ասում են՝ «ձեր ուինդոուսն ի՞նչ ա» հասկանալով կամ զգալով որ այլ, ոչ մայքրոսոֆթի օպերացիոն համակարգ ա։

չեն ընտրում որովհետեւ կամ ստանում են «ուինդոուս» կարգիչ առնելիս, կամ ինչ֊որ մէկը՝ «կամպիւտռշիկ», այն տեղակայում ա։

եթէ այդ մարդը այլ օհ֊ի մասին իմանար կամ չվախենար փորձել, գուցէ կը սկսէր պայմանական «լինուքս» օգտագործել, զի լիքը բան այդ աշխարհում կամ աւելի հեշտ ա լուծւում կամ խնդիրները չեն առաջանում որ դրանք լուծեն։

բայց վախենում ա։ եթէ չվախենար, գուցէ եւ չմնար «կամպիւտռշիկ», կը դառնար անպիտան ադմին, ինչպէս շատերը։ իսկ յետոյ գուցէ եւ պիտանի ադմին։

ի՞նչ ասել այն մարդկանց մասին որ պատրաստ են վճարել «ուինդոուս» տեղակայելու համար՝ իրենց վախն անհամեմատ աւելի մեծ ա՝ զի գաղափար չունեն էդ ինչ մագիա ա ու հազիւ են սովորել մկնիկի եւ «սթարտ» կոճակի տեղը։

եւ «սթարտ» կոճակն ինտերֆէյսում հէնց այդ մարդկանց համար ա՝ միացաւ կարգիչը, ի՞նչ անել՝ ունես մի կոճակ՝ վրան գրուած ա «սթարտ»։ դէ սեղմիր, երեւի։

«լինուքս» ասածն օգտագործելու համար յատուկ գիտելիք կամ հմտութիւն պէտք չի։

պէտք ա պարզ գրագիտութիւն, որը կարգիչներից օգտուողներից քչերն ունեն։ ինչպէս հարիւր տարի առաջ քչերը գիտէին կարդալ։ իսկ մոբայլ սարքերի գալով եւ քչացել ա յոյսն որ այդ պարզ համակարգչային գրագիտութիւնը կունենան։

ով էլ ունի՝ ազատ չի իներցիայի ազդեցութիւիից։

#ազատութիւն

բնօրինակ ծմակուտում(եւ մեկնաբանութիւննե՞ր)