ես համոզուած էի որ գրել եմ ինչպէս օգտագործել լոկալ llm։

բայց չեմ գտնում այդ գրառումը։

ահա՝

python -m venv ~/venvs/llm

. ~/venvs/llm/bin/activate

առաջին տողը ստեղծում ա փայթընի վիրտուալ միջավայր՝ ինչ էնտեղ pip֊ով տեղակայէք, կը մնայ էնտեղ, մեկուսացուած։

ամէն անգամ ապագայում այդ միջավայրը ակտիւացնելու համար պէտք ա կրկնել երկրորդ տողը։

եթէ ձեր pip֊ը աշխատում ա եւ առանց վիրտուալ միջավայրի (էդպէս, տեսել եմ մակօսներում ա, կամ հին լինուքս դիտրիբուտիւներում), ապա կարող էք սա չանել էլ։

հիմա տեղակայենք llm ծրագիրը՝

pip install llm

յետոյ

llm install llm-gpt4all

հիմա եթէ գրէք՝

llm models list

կը կարողանաք տեսնել ինչ մոդելներ կան, որոնց հետ կարող էք խօսել, էս պահին ինձ մօտ հետեւալն ա բերում՝

$ llm models list ??

OpenAI Chat: gpt-3.5-turbo (aliases: 3.5, chatgpt)

OpenAI Chat: gpt-3.5-turbo-16k (aliases: chatgpt-16k, 3.5-16k)

OpenAI Chat: gpt-4 (aliases: 4, gpt4)

OpenAI Chat: gpt-4-32k (aliases: 4-32k)

OpenAI Chat: gpt-4-1106-preview

OpenAI Chat: gpt-4-0125-preview

OpenAI Chat: gpt-4-turbo-preview (aliases: gpt-4-turbo, 4-turbo, 4t)

OpenAI Completion: gpt-3.5-turbo-instruct (aliases: 3.5-instruct, chatgpt-instruct)

gpt4all: Meta-Llama-3-8B-Instruct - Llama 3 Instruct, 4.34GB download, needs 8GB RAM (installed)

gpt4all: all-MiniLM-L6-v2-f16 - SBert, 43.76MB download, needs 1GB RAM

gpt4all: all-MiniLM-L6-v2 - SBert, 43.82MB download, needs 1GB RAM

gpt4all: nomic-embed-text-v1 - Nomic Embed Text v1, 261.58MB download, needs 1GB RAM

gpt4all: nomic-embed-text-v1 - Nomic Embed Text v1.5, 261.58MB download, needs 1GB RAM

gpt4all: replit-code-v1_5-3b-newbpe-q4_0 - Replit, 1.82GB download, needs 4GB RAM

gpt4all: orca-mini-3b-gguf2-q4_0 - Mini Orca (Small), 1.84GB download, needs 4GB RAM

gpt4all: Phi-3-mini-4k-instruct - Phi-3 Mini Instruct, 2.03GB download, needs 4GB RAM

gpt4all: mpt-7b-chat - MPT Chat, 3.54GB download, needs 8GB RAM

gpt4all: orca-2-7b - Orca 2 (Medium), 3.56GB download, needs 8GB RAM

gpt4all: rift-coder-v0-7b-q4_0 - Rift coder, 3.56GB download, needs 8GB RAM

gpt4all: mpt-7b-chat-newbpe-q4_0 - MPT Chat, 3.64GB download, needs 8GB RAM

gpt4all: em_german_mistral_v01 - EM German Mistral, 3.83GB download, needs 8GB RAM

gpt4all: mistral-7b-instruct-v0 - Mistral Instruct, 3.83GB download, needs 8GB RAM

gpt4all: ghost-7b-v0 - Ghost 7B v0.9.1, 3.83GB download, needs 8GB RAM

gpt4all: Nous-Hermes-2-Mistral-7B-DPO - Nous Hermes 2 Mistral DPO, 3.83GB download, needs 8GB RAM

gpt4all: mistral-7b-openorca - Mistral OpenOrca, 3.83GB download, needs 8GB RAM

gpt4all: gpt4all-falcon-newbpe-q4_0 - GPT4All Falcon, 3.92GB download, needs 8GB RAM

gpt4all: gpt4all-13b-snoozy-q4_0 - Snoozy, 6.86GB download, needs 16GB RAM

gpt4all: wizardlm-13b-v1 - Wizard v1.2, 6.86GB download, needs 16GB RAM

gpt4all: orca-2-13b - Orca 2 (Full), 6.86GB download, needs 16GB RAM

gpt4all: nous-hermes-llama2-13b - Hermes, 6.86GB download, needs 16GB RAM

gpt4all: starcoder-newbpe-q4_0 - Starcoder, 8.37GB download, needs 4GB RAM

հիմա, եթէ մի հատ հարց ես ուզում տալ, ու մի պատասխանով բաւարարուելու ես, ապա՝

llm -m Meta-Llama-3-8B-Instruct

ինքը կը քաշի էս մէկը (չորս գբ ա զբաղեցնում) ~/.cache/gpt4all ֊ի մէջ։

$ ls ~/.cache/gpt4all/ -lh

total 4.4G

-rw-r--r-- 1 inky inky 4.4G Ապր 27 07:08 Meta-Llama-3-8B-Instruct.Q4_0.gguf

ու դրանից յետոյ կը կարողանաս խօսել իր հետ։

այլապէս, կարող ես պահել այն յիշողութեան մէջ ու նոյն թեմայի մասին էլի խօսել՝

llm chat -m Meta-Llama-3-8B-Instruct

կարող ես իհարկէ նշել այլ մոդել։

աւելի «հեշտ» ձեւն ա՝ lm studio օգտագործելը։ համոզուած չեմ որ ազատ ա։ ես էսպէս եմ անում։

նաեւ, էս ամէն մոդելն ունի իր սպեցիֆիկ օպցիաները։

$ llm models list --options

OpenAI Chat: gpt-3.5-turbo (aliases: 3.5, chatgpt)

temperature: float

What sampling temperature to use, between 0 and 2. Higher values like

0.8 will make the output more random, while lower values like 0.2 will

make it more focused and deterministic.

max_tokens: int

Maximum number of tokens to generate.

top_p: float

An alternative to sampling with temperature, called nucleus sampling,

where the model considers the results of the tokens with top_p

probability mass. So 0.1 means only the tokens comprising the top 10%

probability mass are considered. Recommended to use top_p or

temperature but not both.

frequency_penalty: float

Number between -2.0 and 2.0. Positive values penalize new tokens based

on their existing frequency in the text so far, decreasing the model's

likelihood to repeat the same line verbatim.

presence_penalty: float

Number between -2.0 and 2.0. Positive values penalize new tokens based

on whether they appear in the text so far, increasing the model's likelihood to talk about new topics.

stop: str

A string where the API will stop generating further tokens.

logit_bias: dict, str

Modify the likelihood of specified tokens appearing in the completion.

Pass a JSON string like '{"1712":-100, "892":-100, "1489":-100}'

seed: int

Integer seed to attempt to sample deterministically

json_object: boolean

Output a valid JSON object {...}. Prompt must mention JSON.

OpenAI Chat: gpt-3.5-turbo-16k (aliases: chatgpt-16k, 3.5-16k)

temperature: float

max_tokens: int

top_p: float

frequency_penalty: float

presence_penalty: float

stop: str

logit_bias: dict, str

seed: int

json_object: boolean

OpenAI Chat: gpt-4 (aliases: 4, gpt4)

temperature: float

max_tokens: int

top_p: float

frequency_penalty: float

presence_penalty: float

stop: str

logit_bias: dict, str

seed: int

json_object: boolean

OpenAI Chat: gpt-4-32k (aliases: 4-32k)

temperature: float

max_tokens: int

top_p: float

frequency_penalty: float

presence_penalty: float

stop: str

logit_bias: dict, str

seed: int

json_object: boolean

եւ այլն։

մեր դէպքում՝

gpt4all: Meta-Llama-3-8B-Instruct - Llama 3 Instruct, 4.34GB download, needs 8GB RAM (installed)

max_tokens: int

The maximum number of tokens to generate.

temp: float

The model temperature. Larger values increase creativity but decrease

factuality.

top_k: int

Randomly sample from the top_k most likely tokens at each generation

step. Set this to 1 for greedy decoding.

top_p: float

Randomly sample at each generation step from the top most likely

tokens whose probabilities add up to top_p.

repeat_penalty: float

Penalize the model for repetition. Higher values result in less

repetition.

repeat_last_n: int

How far in the models generation history to apply the repeat penalty.

n_batch: int

Number of prompt tokens processed in parallel. Larger values decrease

latency but increase resource requirements.

հիմա կարելի ա կանչել էսպէս՝

$ llm chat -m Meta-Llama-3-8B-Instruct --option max_tokens 5

Chatting with Meta-Llama-3-8B-Instruct

Type 'exit' or 'quit' to exit

Type '!multi' to enter multiple lines, then '!end' to finish

> i just ran you with --option max_tokens 5 and i would like to understand if it work.

I see that you're

>

ահա, աշխատում ա։

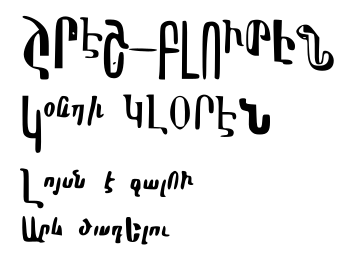

ու տէնց

#աբօ #աբ #արհեստական_բանականութիւն